Nästa datorgeneration bygger på neuralnät

av Bjarne Nyman Forum 1993-06, sida 19-20, 29.04.1993

Näst datorgeneratio bygger på

NEURALNA

Bjarne Nyman

Datatekniken upplever generationsväxlingar ungefär som människor och djur. De datorer vi idag umgås med brukar räknas till den fjärde generationen och om de råkar vara utrustade med artificiell intelligens hör de til femte generationen.

Följande datorgeneration håller nu på att ta form. Folk branschen talar om sjätte generationens datorer, där s.k. neurala nätverk kommer att spela en avgörande roll.

et stora problemet för dagens datortillverkare är att man befinner sig i en återvändsgränd på hårdvaruteknikens område. Marginalerna håller på att ta slut. Idag går det ännu att göra allt mindre och effektivare integrerade kretsar, men väggen kommer obönhörligen emot en vacker dag. När detta sker är bara en tidsfråga.

Inom datalogin har man därför under de senaste åren gått ”back to basics” för att försöka finna andra vägar, d.v.s. nya sätt att bygga upp de fundamentala beräkningsstrukturerna. Nu — liksom då det begav sig — är den mänskliga hjärnan igen i blickpunkten. ”Elektroniska hjärnor” vill man såsom på 40-talet inte tala om, men medger gärna att den mänskliga hjärnan fungerar som inspiration för kreativiteten på området.

Redan benämningarna ”neurala nätverk” eller ”neuralnät” associerar till människans hjärnfunktioner.

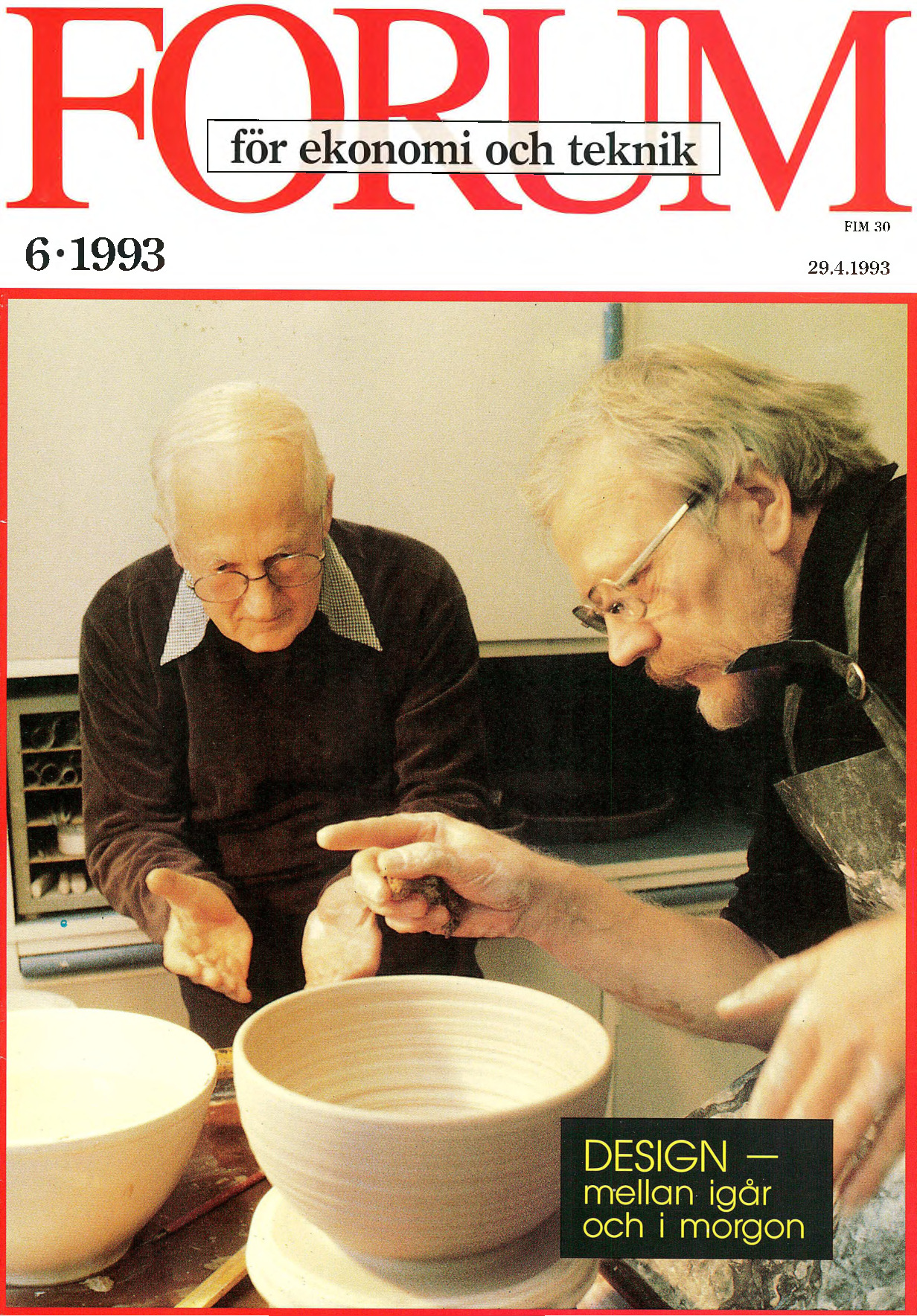

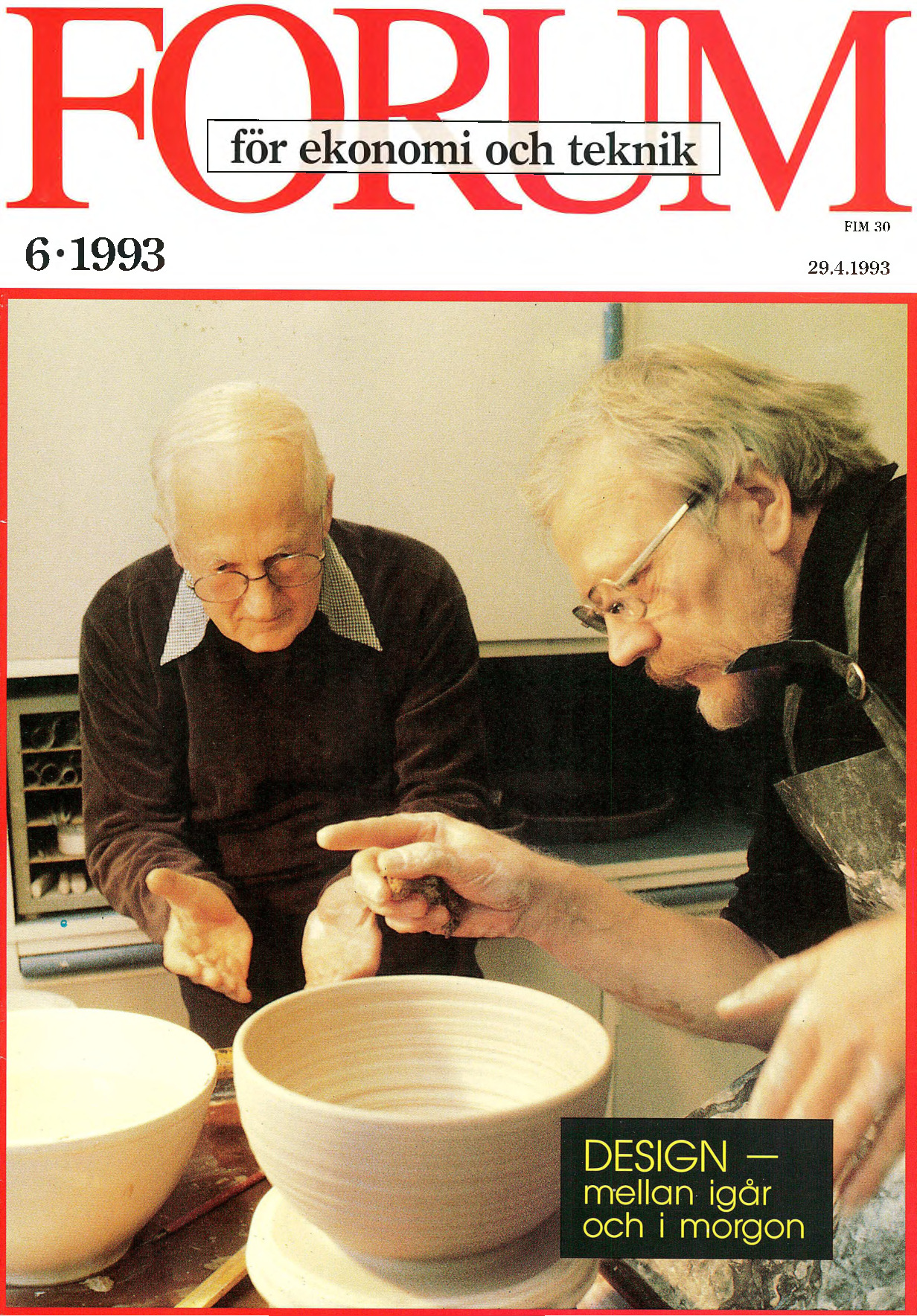

— Visst kan man dra vissa paralleller mellan dagens forskning i neuralnät och den mänskliga hjärnan, säger fil dr Patrik Floréen vid Helsingfors universitets institution för datologi, som nyligen presenterade sin doktorsavhandling just om artificiella neuralnät.

— I båda fallen är det fråga om ett stort antal neuroner, som samverkar parallellt. Men mera än så är det inte. I ett neuralnät försöker vi på sätt och vis efterapa vissa drag i den mänskliga hjärnaktiviteten. Men de matematiska modeller vi arbetar med är dock — trots sin komplexa natur — alltför simpla för ens behjälpligt kunna jämföras med en naturlig hjärna.

Den som vet hur en ölflaska ser ut behöver bara se flaskans hals för ”image processing”…

Ytterst enkla beräkningselement

Det är inte underligt att den mänskliga hjärnan åter en gång inspirerar dataforskarna. Människans nervsystem har omkring 10! 1010 000 000 000 -— 00 000 000 000) neuroner, som — trots att de i sig arbetar långsamt — tillsammans kan utföra komplicerade uppgifter, t.ex. att omvandla de ljussignaler som träfar ögat till en bild i hjärnan (datamänniskorna brukar kalla detta ”image processing”). Dessutom kan hjärnan behandla ofullständig eller oriktig information och ära sig av erfarenhet. Ytterligare positiva egenskaper är att en hjärna är relativt liten och förbrukar endast små mängder energi.

Idealet för en dator alltså.

I ett artificiellt neuralt nätverk uppstår eräkningskraften när många, mycket enkla processorer — neutroner eller beräkningselement — jobbar parallellt. De enskilda neuronerna är vanligen så enkla, att de saknar lokalt minne och kan endast uppnå olika aktivitetsnivåer. Nivån ändras beroende av på vilka nivåer neuronerna i grannskapet befinner sig. Hur stor ändringen blir beror av styrkan i kopplingen mellan neuronerna.

Beräkningen sker när neuronernas tillstånd uppdateras upprepade gånger ända Vän 1 tills ingen förändring längre sker. Nätet har då konvergerat och beräkningen är klar.

Det är uttryckligen styrkan i kopplingarnå som är avgörande för hur beräkningen utfaller och all den information som neuronerna behöver för sina beräkningar är kodad i dessa kopplingar. Att programmera ett neuralnät är därför detsamma som all ändra på styrkegraden i kopplingarna.

Programmering vill datalogerna dock inte tala om i detta sammanhang. Ordet kan i stället ersättas med begreppet inlärning. d.v.s. neutralnätet kan läras att utföra beräkningar enligt ett vi När ett neuralnät fätt lära sig vissa grundläggande fakta, t.ex. när det lärt sig formen på ett visst föremål, kan det sluta sig till att et annat föremål egenligen har samma form, trots att det får information om bara en del av föremålet i fråga. Med andra ord kan felaktig eller ofullständig information ge rätt svar. Neuralnätet har alltså lärt sig ati generalisera på ctt vettigt sätt.

Den mänskliga hjärnan fungerar på samma sätt. Den som vet hur t.ex. en ölflaska ser ut kan på basen av en hals från

Fil dr Patrik Floréen,28, vid HU:s Institution för datalogi har i sin doktorsavhandling undersökt neurala nätverk, som kan komma att utgöra grunden för vår nästa datorgeneration.

2 en liknande flaska sluta sig till hur originalet i tiden såg ut. Det kallas association.

Associativa minnen forskningsfokus

Det finns enligt Patrik Floréen tre huvudorsaker till att neurala nätverk har blivit intressanta forskningsobjekt. Den viktigaste orsaken är att det numera finns teknik för att implementera dylika nätverk i härdvara. Hundratusentals neuroner i effektiv hårdvara kan ge massiv parallell beräkningskraft.

— Halvledargrindar är cn miljon gånger nabba som biologiska neuroner. Men sst finns det problem. Ett neuralnät kräver ju cnorma mängder av kopplingar mellan neuronerna, n st neuroner kan behöva n” antal kopplingar. vilket är ett stort problem med dagens teknik, konstaterar Patrik Floréen. Optiska datorer kan ge en lösning, men det får framtiden utvisa.

Den andra och tredje orsaken har ytligt berörts ovan, d.v.s neuralnätens förmåga att generalisera på ett förnuftigt sätt och möjligheten att övergå från programmering till inlärning.

Ett av de centralaste ämnena för forskning är idag associativa minnen. De var även [öremål för stor uppmärksamhet redan på 5350-talet fram till mitten av 70-talet, men intresset sjönk. när det inte gick att få fram praktiska tillämpningar. Idag ä situationen dock en annan och intresset är stort.

Ett associativt minne kan — som namnet säger — känna igen mönster och på basen av ofullständig information ge rätt lösning. Det kan användas t.ex. för att komprimera stora mängder data till en uppsättning kodord. Ett annat associativt minne med rätt ”uppfostran” ger ut informationen korrekt på basen av inkommande kodord.

Andra användningsområden är bildidentifiering och bildrekonstruktion. Ett associativt minne som lärt sig allt om t.ex. Johann Sebastian Bach kan ge ut hela hans biografi på basen av ofullständig inmatning av vissa referenser. Och märkväl: det är inte fråga om att informationen fysiskt skulle vara lagrad i minnet — såsom i dagens datorer och skivminnen — utan neuralnätet ”förstår” på basen av indata och kopplingarna mellan neuronerna att det är Bach man vill veta mera om. När neuralnätet konvergerat är biografin klar.

Andra föreslagna tillämpningar sökning i stora databaser, expertsystem med stora mängder regler, seende robotar, osv.

Neuralnät på VLSI-kiselbrickor

Forskarna sysslar idag till största delen med att simulera sina neuralnätsteorier på vanliga datorer. Men det finns redan nu enkla neuralnät att tillgå på VLSI-kretsar (Yery Large Scale Integration). Också praktiska applikationer existerar.

Vid Tekniska högskolan har artificiella neuralnät med vissa framgångar använts t.ex. i en fonetisk skrivmaskin. Användaren lär maskinen förstå tal genom att prata med den. När samma person sedan dikterar brev med samma artikulation skriver maskinen ut brevet.

I USA och Japan ses neuralnät som big business. Japanerna utnyttjar neuralnätens positiva framtidsklang till och med i TVreklam i direkt PR-syfte. I USA tycks Pentagon — såsom ofta tidigare när det gäller ny teknik — visa det största intresset. Vissa av flygvapnets attackplan är försedda med neuralnät för att balansera upp planet, jfr snabba associationer. Neuralnät har också börjat användas för målsökning och liknande applikationer.

En amerikansk satellitstyrningsanläggning ute i ödemarken är försedd med ett neuralnät, som inregistrerar värden från ett antal givare och ger på förhand varning om eventuella kommande fel. Tack vare nätet kan anläggningen åtgärdas innan felet hinner uppstå, vilket givetvis sparar pengar.

Ytterligare ett exempel är storbolaget AT&T, som undersöker möjligheten att tolka handskrivna postkoder med neuralnät.

Försök har också gjorts inom musiken. Ett associativt neuralnät kunde ju — åtminstone teoretiskt — bli framgångsrik kompositör genom att först lära sig det som finns att lära sig. Och visst komponerar neuralnätet. Men hittills har det inte — enligt musikkännarna — blivit någon njutning för örat. LJ